Funcionamiento y estructura de las Recurrent Neural Networks

Una Recurrent Neural Network o red neuronal recurrente (también conocida como RNN por sus siglas en inglés) es una red que puede usar retroalimentación, creando así una especie de memoria. Esta técnica se aplica principalmente al manejo de datos secuenciales y requiere un esfuerzo considerable en cuanto a entrenamiento.

¿Qué es una Recurrent Neural Network?

Una red neuronal recurrente es una red neuronal artificial capaz de generar retroalimentación y reintroducir información de salida como nueva entrada. Este método se emplea especialmente para procesar datos secuenciales en el ámbito del aprendizaje profundo y de la inteligencia artificial o IA. Al recibir información de entradas anteriores, la red neuronal recurrente desarrolla una especie de memoria y ajusta las salidas según los elementos previos de la secuencia. Existen diferentes tipos de retroalimentación, lo que aumenta tanto las posibilidades como la complejidad del entrenamiento.

- Crea tu página web en tiempo récord

- Impulsa tu negocio gracias al marketing por IA

- Ahorra tiempo y obtén mejores resultados

¿Cómo funcionan las Recurrent Neural Networks?

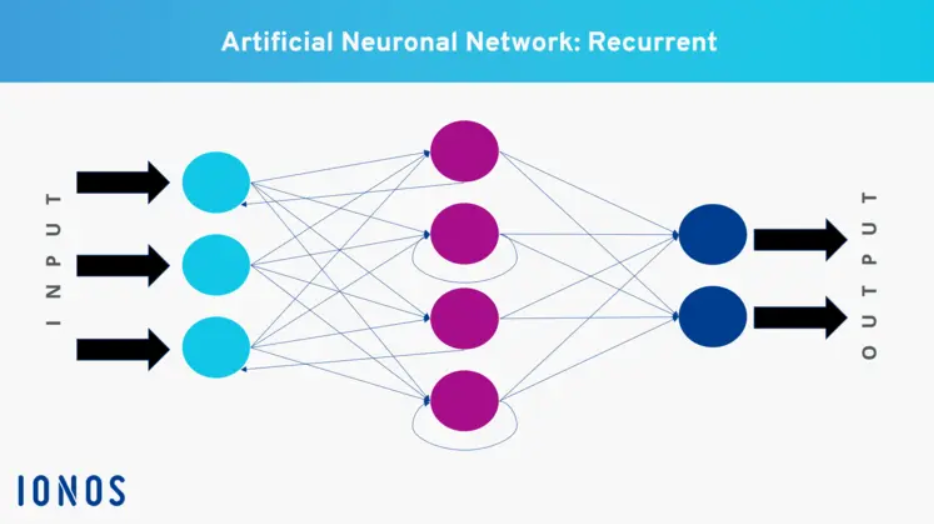

A primera vista, las redes neuronales recurrentes parecen estar estructuradas de manera similar a otras redes neuronales. Constan de al menos tres capas diferentes (en inglés, “layers”), que contienen neuronas conectadas por aristas. Más concretamente, hablamos de una capa de entrada (Input Layer), una capa de salida (Output Layer) y una cantidad variable de capas intermedias, conocidas como capas ocultas (Hidden Layers).

- Capa de entrada: en esta capa, se reciben datos del entorno, que luego se ponderan y se envían a la siguiente capa.

- Capas intermedias: son las Hidden Layers (capas ocultas). Aquí, la información se transfiere y se pondera nuevamente. Este proceso ocurre en cada capa adicional y es invisible, de ahí su nombre.

- Capa de salida: la información evaluada o modificada se emite a través de la Output Layer o capa de salida. Esta salida puede ser el resultado final o puede servir como entrada para otras neuronas.

Lo especial de una red neuronal recurrente es la posibilidad de determinar la dirección del flujo de información. Gracias a la retroalimentación, la salida de una neurona no tiene que ir necesariamente a la siguiente capa, sino que puede reingresar en la misma neurona, en otra neurona de la misma capa o en una neurona de la capa anterior. El parámetro de ponderación es el mismo en todas las capas. La retroalimentación se clasifica en cuatro categorías:

- Retroalimentación directa: la salida de la misma neurona se usa como entrada.

- Retroalimentación indirecta: la salida de una neurona se conecta con una capa anterior.

- Retroalimentación lateral: la salida de una neurona se conecta a la entrada de otra neurona de la misma capa.

- Retroalimentación completa: todas las salidas de las neuronas están conectadas a otras neuronas.

¿Cómo se entrenan las redes neuronales recurrentes?

El entrenamiento de las redes neuronales recurrentes es bastante complejo, ya que la información más antigua a menudo no se tiene en cuenta o no lo suficiente. Para solucionar este problema, se utilizan funciones como la memoria a corto-largo plazo o Long Short-Term Memory (LSTM), que permiten almacenar información durante más tiempo. Con el entrenamiento adecuado, una Recurrent Neural Network o red neuronal recurrente puede distinguir la información importante de la que no lo es y volver a introducir la relevante en la red.

¿Qué arquitecturas existen para estas redes neuronales?

Existen diferentes arquitecturas que distinguen a las redes neuronales recurrentes entre sí. Estas son las más comunes:

- One to many: la Recurrent Neural Network recibe una entrada y genera varias salidas. Un ejemplo práctico es la subtitulación de imágenes, donde a partir de una palabra clave se genera una oración.

- Many to one: se reciben varias entradas que se asocian a una única salida. Este principio se utiliza, por ejemplo, en el análisis de sentimiento, donde se predicen respuestas basadas en referencias anteriores.

- Many to many: se usan varias entradas para obtener varias salidas, pero no tienen que ser necesariamente iguales en número. Esta técnica se utiliza, por ejemplo, en la traducción de un idioma a otro.

¿Cuáles son los principales campos de aplicación de las Recurrent Neural Networks?

Las redes neuronales recurrentes son especialmente útiles cuando el contexto es importante en el procesamiento de la información. Esto es crucial para el manejo de datos secuenciales, que tienen un orden o una secuencia temporal específica. En estos casos, las RNN pueden predecir mejor los resultados al tener en cuenta las entradas anteriores. Entre los campos de aplicación más destacados se encuentran:

- Predicciones y datos de series temporales: las RNN se utilizan para predecir eventos o valores basados en datos históricos, como en el análisis del mercado financiero, la predicción del clima o el consumo de energía.

- Procesamiento del lenguaje natural (NLP): en el ámbito del procesamiento del lenguaje natural o Natural Language Processing, las redes neuronales recurrentes son particularmente útiles. Se emplean en tareas como la traducción automática, el modelado de lenguaje, el reconocimiento de texto y la generación automática de textos.

- Reconocimiento de voz: las Recurrent Neural Networks juegan un papel clave en la tecnología de reconocimiento de voz, donde se utilizan para convertir el habla en texto. Estas aplicaciones se encuentran, por ejemplo, en asistentes digitales y servicios de transcripción automática.

- Análisis de imágenes y vídeos: aunque las redes neuronales recurrentes se usan principalmente para procesar datos secuenciales, también se pueden aplicar al análisis de imágenes y vídeos, especialmente cuando se trata de secuencias de imágenes o vídeos, como en el resumen de vídeos o la detección de actividades en vídeos de vigilancia.

¿En qué se diferencian de una Feedforward Neural Network?

La Recurrent Neural Network es una evolución de las redes neuronales prealimentadas o Feedforward Neural Networks (FNN), que no permiten la retroalimentación. En una FNN, la información fluye siempre en una única dirección hacia la siguiente capa. No es posible una reintroducción hacia capas anteriores. De esta manera, las redes neuronales prealimentadas pueden reconocer patrones, pero no pueden aprovechar la información procesada previamente.