Servidor caído: riesgos, efectos y prevención

Cuando se piensa en la criminalidad en Internet, las empresas suelen preocuparse en primera instancia por el espionaje empresarial, por el robo de datos sensibles y por la consiguiente vulneración de la privacidad y, sin embargo, son los ataques desde la red, que han alcanzado una nueva dimensión debido a la creciente digitalización, la mayor amenaza. Cada vez más sectores comerciales se ven sustentados por sistemas informáticos que conectan a las empresas a las redes públicas, haciéndolas al mismo tiempo más vulnerables a los ataques de hackers. Si el ciberataque tiene como resultado la caída del servidor de una compañía, esto puede conllevar una interrupción muy cara de su servicio, pudiendo ascender fácilmente, en el plazo de unos pocos minutos, a las cuatro cifras. Estas graves pérdidas suponen una amenaza en particular para aquellas empresas cuyo servidor aloja un software de eCommerce o bases de datos centralizadas. No obstante, conviene saber que las caídas del servidor no vienen ocasionadas exclusivamente por factores externos, sino que también existen riesgos internos que amenazan el buen funcionamiento del servidor.

Además de la protección frente amenazas externas y de los estándares de actuación propios de una estrategia de recuperación de desastres, un plan sólido de seguridad también contiene medidas de acción en cuanto a organización y personal. La prevención suele basarse en la compensación, que consiste técnicamente en poner a disposición hardware redundante para garantizar su alta disponibilidad, o en franquear períodos de caída mediante sistemas de espera o stand by. En lo que respecta a la protección de la información, los administradores aseguran los datos por medio de diversos softwares para realizar copias de seguridad y recuperar la información, así como con una arquitectura redundante de almacenamiento. Las consecuencias económicas ocasionadas por un servidor caído solo se pueden salvar con un seguro.

¿Por qué se cae un servidor?

Entre las causas de caída de un servidor, los expertos diferencian entre amenazas internas y externas. Entre las primeras se encuentran todos aquellos escenarios en los que la propia infraestructura informática, la alimentación eléctrica o un error humano son los desencadenantes, mientras que entre las segundas se incluyen los ataques planificados desde el exterior y acontecimientos imprevisibles, tales como accidentes o catástrofes naturales.

Riesgos internos:

- Incendio en el centro de datos

- Fallo del suministro eléctrico en el centro de datos

- Avería de hardware: caída del disco duro, sobrecarga, recalentamiento

- Fallo en el software: caída de la base de datos

- Problemas de red

- Error humano

Riesgos externos:

- Infiltración: ataque man in the middle, phishing, ingeniería social

- Sabotaje: ataques en sistemas SCADA

- Virus, troyanos, gusanos

- Ataque distribuido de denegación del servicio (DDoS)

- Robo de hardware

- Causa de fuerza mayor: terremoto, rayo, inundación

- Accidentes (accidente de aviación)

- Atentado

Generalmente, a las empresas les resulta mucho más sencillo prepararse ante los riesgos internos para la seguridad que ante los externos, principalmente porque los cibercriminales adaptan continuamente sus patrones de ataque a los estándares de seguridad más actuales, haciéndoles la vida muy difícil con nuevos programas infecciosos o estrategias de infiltración. Por el contrario, equiparse para hacer frente a las amenazas internas para la seguridad de los servidores consiste en tomar medidas factibles como un sistema de alimentación sin interrupciones, medios antiincendios, un servidor de alta disponibilidad y cursos de formación para los empleados.

¿Qué pasa cuando caen los servidores?

La caída de un servidor ocasiona, en primer lugar, pérdidas económicas, algo de lo que es claramente consciente la mayor parte de las empresas. Ahora bien, ¿se sabe cuánto cuesta exactamente una hora sin servidor? Un estudio de la consultora Techconsult de 2013 impulsado por HP Alemania examinó a 300 empresas medianas del país teutón (de 200 a 4.999 empleados) y, de estas, un 77 % confesó haber sufrido fallos críticos en sus sistemas informáticos en el año previo al estudio. Las empresas más afectadas fueron las de los sectores del comercio, la fabricación y la distribución. La media de caídas del servidor en el período objeto del estudio fue de cuatro apagones por empresa con una duración media de 3,8 horas, en las cuales se incluyen la reparación técnica y la recuperación de los datos.

Los costes que se generan por cada hora de no funcionamiento varían en función del tamaño de la empresa, teniendo en cuenta, además, que en ellos confluyen tanto los gastos de producción (cuánto tiempo se ve privado un empleado de realizar su tarea) como los gastos llamados de oportunidad (ventas y tomas de contacto en la página web, quizá irrecuperables). Mientras que aquellas empresas con menos de 500 empleados confirmaron haber sufrido daños de alrededor de 20.000 euros por hora, los costes para las empresas con más de mil trabajadores ascendieron a cerca de 40.000. Así, una caída del sistema puede significar para una empresa de tamaño medio un coste de 25.000 euros por hora sin servicio. Si se añaden los costes de la reparación de la avería y de la restauración de los datos, los efectos de un servidor caído resultan en una pérdida anual de 380.000 euros para la mediana empresa alemana. Es razonable extrapolar estas conclusiones al ámbito global de forma que las cifras tendrían un aspecto similar en otros países con una actividad empresarial equiparable.

La forma en que la caída de un servidor entorpece el funcionamiento de una empresa y si lo hace depende en gran medida de su sector y de su modelo comercial. En principio, los empleados deberían poder cambiar de tarea y, por ejemplo, convocar meetings, realizar llamadas telefónicas o planificar citas con clientes. Sin embargo, cuando los procesos centrales no solo se apoyan en sistemas informáticos, sino que dependen completamente de ellos, un apagón de este tipo es especialmente grave. Cuando una tienda online, por poner un solo ejemplo, permanece offline durante un período indefinido de tiempo, tendrá que enfrentarse a importantes pérdidas al no poder realizarse pedidos en su página, así como una caída del sistema SCADA podría ocasionar una interrupción de la producción.

En definitiva, el cálculo de las pérdidas económicas vinculadas a un apagón del servidor no se hace solo considerando el coste por hora en relación con aquellos empleados que se vieron impedidos en su actividad laboral, sino también aquellas determinadas por la imposibilidad de realizar pedidos y compras, así como los gastos ocasionados por posibles sanciones mercantiles. A ello habría que añadir aquellos daños incuantificables que afectan a la imagen de la empresa.

Medidas preventivas para evitar una caída del servidor

La mejor manera de evitar un fallo en el servidor es adelantarse a riesgos específicos mediante medidas de seguridad informática enfocadas a la protección de la infraestructura computacional y que tienen relación, por regla general, con una serie de acciones infraestructurales y organizativas que afectan a la elección y al diseño del lugar donde se instalan los servidores.

En España, el Instituto Nacional de Ciberseguridad o INCIBE, dependiente de Red.es y del Ministerio de Industria, es el organismo de control encargado de proveer las recomendaciones de seguridad informática. En su página web el usuario dispone de una exhaustiva recopilación de información actualizada y puede acceder a una gran variedad de guías y recursos tanto para empresas, como para los propios internautas. En México, el Equipo de Respuesta a Incidentes de Seguridad en Cómputo de la Universidad Autónoma de México, la UNAM CERT, se encarga de examinar las vulnerabilidades de los sistemas informáticos en el país, de proveer información sobre riesgos de seguridad informática y de proporcionar respuesta a entidades que han sufrido algún ataque.

Protección ante incendios y del suministro eléctrico

Para evitar apagones del servidor por causas físicas tales como incendios, inundaciones, fluctuaciones en la alimentación o sabotajes del hardware, las salas de los servidores y los centros de datos han de observar ciertas medidas de seguridad. Todo comienza ya con la elección de su localización, para lo cual, por ejemplo, se deben desestimar los sótanos, ya que implican el riesgo de inundación por tormentas o catástrofes naturales. El acceso debería limitarse al personal autorizado y, si fuera necesario, protegerse con controles de seguridad. No olvidemos que la habitación donde se guardan los servidores no es un lugar de trabajo permanente.

Ante el riesgo de incendio, los sistemas de prevención y extinción compensan los posibles daños ocasionados por un accidente de este tipo. Aquí se incluye la instalación de puertas cortafuegos, sistemas de alarma, extintores de mano y sistemas de extinción automática. Otras medidas adicionales de seguridad incluyen el almacenamiento seguro de materiales inflamables, el aislamiento del cableado y la utilización de los materiales de aislamiento térmico y de insonorización adecuados.

Los aparatos técnicos transforman la energía eléctrica en calor, de tal forma que la luz directa en la habitación podría ocasionar un aumento perjudicial de la temperatura. Para evitar caídas del servidor y errores en los datos debido al sobrecalentamiento y a una humedad demasiado alta deberían instalarse sistemas de ventilación y enfriamiento de gran potencia. Las condiciones ambientales óptimas para sistemas de almacenamiento a largo plazo se alcanzan entre los 20 y los 22°C y una humedad del aire del 40 por ciento.

Por último, hay que tener en cuenta que la condición fundamental para el buen funcionamiento de un sistema informático es la estabilidad del flujo eléctrico. Según los expertos, una interrupción de más de 10 ms podría ser responsable de fallos en el servidor. Los generadores de emergencia pueden ayudar a solventar estos apagones, ya que, al no depender de la red eléctrica pública, permiten el funcionamiento temporal autónomo de la instalación informática, evitando una interrupción del servicio.

Seguridad ante caídas

Las empresas de tamaño medio son las que más subestiman los efectos de las averías informáticas en su funcionamiento global. Uno de los motivos radica en la alta fiabilidad de los componentes estándar utilizados hoy día en la infraestructura informática corporativa, cuya disponibilidad se estima por regla general en un 99,9 %. Este valor, aunque aparentemente alto, implica, sin embargo, una caída de una duración de casi 9 horas en un año en un sistema que funciona sin pausa. Si esta caída tiene lugar en horas de máxima actividad comercial, aun siendo mínima, puede conllevar importantes pérdidas para la compañía. Esto ha originado la consolidación de sistemas informáticos de alta disponibilidad (99,99 %) como estándar para garantizar la conservación de datos y aplicaciones especialmente relevantes, unos sistemas que prometen un downtime máximo de 52 minutos al año. Yendo más allá, hoy los expertos hablan de alta disponibilidad a partir de un 99,999 por ciento de disponibilidad, con un margen de caída de 5 minutos como máximo al año. El único problema a la hora de valorar estos datos sobre disponibilidad, es que se limitan a la seguridad del hardware de los servidores. Según la definición del IEEE (Institute of Electrical and Electronics Engineers), un sistema puede considerarse altamente disponible cuando, a pesar del fallo de algunos componentes, puede garantizar la disponibilidad de sus recursos informáticos: “High Availability (HA for short) refers to the availability of resources in a computer system, in the wake of component failures in the system.” Esto se logra, por ejemplo, mediante servidores completamente redundantes, en los cuales los componentes cruciales para su funcionamiento, como procesadores, chips de almacenamiento y unidades I/O están repetidos, de tal forma que, por un lado, se impide que un componente defectuoso ocasione un fallo en el servidor, pero que, por el contrario, no ofrece protección ante un incendio en el centro de datos, ataques planificados con software dañino y ataques DDoS, sabotaje o el secuestro del servidor por parte de un hacker. Para las empresas esto implica, por consiguiente, padecer apagones más largos y considerar la necesidad de tomar las medidas de contingencia correspondientes. Otras estrategias recurren a sistemas stand by y a clústers de alta disponibilidad, ambos basados en un conjunto de dos o más servidores que globalmente disponen de más recursos de hardware de los que se necesitan para su funcionamiento normal. Los sistemas de espera están basados en un servidor alternativo que, a modo de servidor de seguridad del sistema primario, se hace cargo de las tareas del primero tan pronto como este falla debido a una avería de software o de hardware, lo que se denomina failover y tiene lugar automáticamente, sin intervención del administrador, mediante un software de gestión de clústeres. Una estructura de este tipo, compuesta por un nodo activo y otro pasivo, puede ser considerada un clúster asimétrico altamente disponible, opuesto a uno simétrico, que sería aquel en el que todos los nodos del clúster están disponibles al mismo tiempo en funcionamiento normal. Sin embargo y con motivo del retraso que origina la migración de un servicio de un sistema a otro, en los sistemas stand by y en los clústeres altamente disponibles no es posible evitar por completo una interrupción del servicio, aunque sea muy breve.

Sistemas de defensa

Ante los dañinos efectos de las acciones de los hackers, los administradores recurren a diversas soluciones de software y hardware cuya función es la de detectar, rechazar, señalar y desviar sus ataques. Para proteger a un servidor de accesos no autorizados, los sistemas más críticos se aíslan de la red pública mediante cortafuegos o firewalls y zonas desmilitarizadas (DMZ).

Los llamados Intrusion Detection Systems (IDS) consisten en sistemas de detección de ataques que, mediante el reconocimiento de patrones y el análisis estadístico, permiten la supervisión automática de los servidores y las redes y disparan la alarma tan pronto como se registran intentos de irrupción manuales o ataques automatizados mediante malware. Si se utilizan Intrusion Prevention Systems (IPS), tras la alarma se llevan a cabo medidas de protección automáticas. Es frecuente conectarlo al firewall, de tal forma que este pueda rechazar paquetes de datos o interrumpir conexiones dudosas.

Otra forma de mantener a los cibercriminales alejados de la infraestructura informática más importante para la empresa son los honeypots, programas que, simulando objetivos atractivos para los atacantes, hacen las veces de anzuelo y que, al funcionar independientemente del sistema productivo, no tienen ningún impacto en su actividad normal. Los honeypots son monitorizados constantemente por los administradores, de tal forma que permiten reaccionar con prontitud a posibles intrusiones y analizar tanto el patrón de ataque como la estrategia que se ha utilizado.

Protección y restauración de los datos

Por ley, las empresas están obligadas a contar con una política de seguridad que proteja la información sensible de la que son responsables y garantice la continuidad de su servicio. En concreto, la Ley Orgánica de Protección de Datos de carácter personal española (LOPD) determina las medidas básicas de protección y almacenamiento de la información personal, mientras que el Esquema Nacional de Seguridad (ENS), regulado por Real Decreto 3/2010, de 8 de enero y establecido en el artículo 42 de la Ley 11/2007, de 22 de junio, de acceso electrónico de los ciudadanos a los Servicios Públicos, regula la política de seguridad en los medios electrónicos. Por su parte, el estándar industrial para la seguridad de la información ISO/IEC 27001 fijado por la International Organization for Standardization y por la comisión International Electrotechnical Commission certifica a las empresas que disponen de un sistema de gestión de la seguridad de la información según sus requisitos, situados muy cerca de las especificaciones legales españolas.

La norma ISO/IEC 27001 no solo determina a los responsables de la seguridad de los datos y quién puede llevar a cabo una restauración de la información en caso necesario, sino que establece cuándo han de ser realizadas las copias de seguridad, cuántas generaciones se almacenan, qué medio de almacenamiento se utiliza, si se requieren condiciones especiales en la transferencia como el cifrado y los tipos de copias de seguridad, que se resumen en:

- Copia completa: de fácil suposición, esta consiste en el depósito de todos los datos en un disco en un momento específico. En este tipo de back up no se revisa si los datos han cambiado desde la última copia, por lo que necesita mucho tiempo y espacio de almacenamiento, que se pone de manifiesto sobre todo cuando se guardan paralelamente varias generaciones. Por otro lado, este tipo de copia tiene la ventaja de que los datos se recuperan fácil y rápidamente al tener que reconstruir solo el último estado de la copia, una ventaja que, sin embargo, no aprovechan aquellas empresas que solo realizan back ups de forma esporádica. En este caso el trabajo posterior es mayor, ya que hay que adaptar los archivos modificados con posterioridad al estado actual.

- Copia incremental: este procedimiento solo tiene en cuenta los archivos que han sufrido cambios desde la última copia, suponiendo un ahorro, no solo de tiempo a la hora de realizar la copia, sino también de espacio necesario para almacenar diferentes generaciones, mucho menor que en el caso anterior. Eso sí, la copia incremental presupone la existencia de al menos una copia completa, lo que hace que en la práctica suelan combinarse ambos métodos, generando, por ejemplo, varios back ups incrementales entre dos copias completas. A la hora de restablecer los datos se toma como referencia la última copia completa, que se complementa con los datos de los ciclos de almacenamiento incremental. Generalmente requiere comparar varias copias consecutivas.

- Copia diferencial: este tipo de copia de seguridad también necesita una copia completa anterior y también registra solo la información nueva desde la última copia, pero, a diferencia de la incremental, los back ups no se encadenan. Para recuperar los datos solo es necesario parangonar la última copia completa con la copia diferencial más actual.

A la hora de decantarse por una u otra estrategia de seguridad, los requisitos de disponibilidad y el planteamiento comercial de las empresas son los que inclinan la balanza. Entre los factores más influyentes se encuentran unos tiempos de restauración tolerables, la frecuencia y el momento de la copia de seguridad, así como la relación entre el volumen de los cambios y el volumen global de la información. Si estos dos últimos son casi idénticos, el ahorro de espacio resultante de los procedimientos incrementales o diferenciales es mínimo.

Educar a los empleados

A nivel corporativo, la única forma de consolidar las medidas de seguridad de la información es hacer que todos los empleados las reconozcan y acepten como una parte esencial del éxito comercial de la empresa. Esta conciencia solo se construye y cuida mediante cursos regulares en los que los empleados se sensibilizan ante los riesgos internos y externos, se recrean escenarios específicos y se muestran las posibles consecuencias.

Estas formaciones sistemáticas se construyen sobre la base de una normativa y unas especificaciones referentes al manejo de dispositivos e instalaciones críticos en cuanto a seguridad, así como de un plan de emergencia que ofrece a los empleados instrucciones concretas de actuación para saber cuáles son los pasos a iniciar para restablecer el funcionamiento normal lo antes posible. Con la denominada gestión de la continuidad del negocio se cuenta con un enfoque estructurado para la elaboración del concepto correspondiente.

Gestión de la continuidad del negocio (BCM)

Para minimizar los daños ocasionados por un servidor caído, las empresas invierten de forma creciente en medidas de prevención, de entre las cuales destaca la disciplina de gestión de continuidad del negocio o BCM (Business Continuity Management), que, en el sector informático, sitúa el foco de atención en responder ante una avería en el servidor de sectores cruciales para la empresa y, en el caso de una interrupción, garantizar una inmediata puesta en marcha. La realización de un análisis del impacto en el negocio o BIA (Business Impact Analyse), una herramienta mediante la cual las empresas pueden identificar procesos de negocio críticos, es una condición fundamental en este concepto de gestión de emergencias y es entendido por críticos como aquellos procesos cuya baja tendría efectos significativos en el funcionamiento de la empresa. Para ello, este análisis se concentra, en primer lugar, en las consecuencias de escenarios concretos. Las causas de una caída del servidor, la probabilidad de que ciertos riesgos se puedan producir y las medidas de reacción a adoptar son recogidas en el análisis de riesgos, del que se hablará más adelante. Las empresas cuentan hoy con diversos estándares y guías que se ocupan de la realización metódica del análisis del impacto en el negocio y del análisis de riesgos en el marco de la gestión de continuidad del negocio. De nuevo te recomendamos una visita a la página del INCIBE si necesitas más información al respecto.

Análisis de impacto en el negocio (BIA)

El primer paso a tomar en el marco de la gestión de la continuidad del proyecto es el análisis de impacto en el negocio, en el que se evalúan cuáles son los sistemas centrales que garantizan el funcionamiento de la empresa y las consecuencias de un fallo. Para ello, un buen comienzo es identificar los productos y servicios más relevantes de una empresa, así como su infraestructura informática de base. Si la actividad de una empresa se centra, por ejemplo, en la venta por Internet, los servidores encargados de alojar la tienda online y todas sus bases de datos son los sistemas más críticos y, por tanto, de protección prioritaria. Una central telefónica de atención al cliente, por el contrario, clasificaría como crítico para el negocio el fundamento técnico de la instalación telefónica. En definitiva, el análisis de impacto en el negocio debe contener una categorización de los sistemas a proteger en función de su prioridad para el negocio, un cálculo de daños y una evaluación de los recursos necesarios para una reanudación de los sistemas. En la página web oficial del INCIBE cuentas, entre otros recursos, con esta plantilla básica para realizar un BIA.

Análisis y evaluación de riesgos

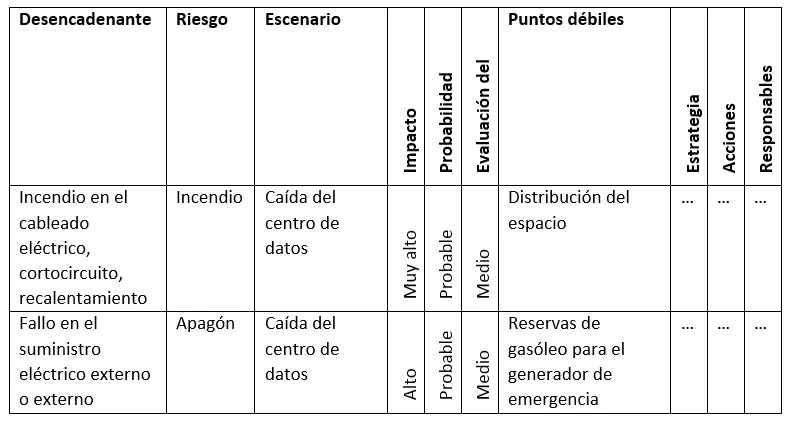

El análisis de contingencias en el marco de la gestión de emergencias permite identificar factores potenciales de riesgo que podrían resultar en una caída del servidor y en la consiguiente interrupción de las actividades de la empresa. El objetivo de esta fase de análisis es poner de relieve los riesgos para la seguridad, así como sus desencadenantes, para poder desarrollar acciones de respuesta adecuadas orientadas a minimizar el riesgo detectado. La valoración de los riesgos se establece a partir del grado de daño que se espera y de la probabilidad de que se produzca, como en el ejemplo de esta tabla de la oficina federal alemana para la seguridad informática (Estándar 100-4):

Identificación de la situación real

Una vez identificados en el BIA y en el análisis de riesgos tanto los peligros como el posible perjuicio de escenarios concretos, en un tercer paso se trata de registrar la situación actual, prestando atención, para ello, a las medidas de prevención de emergencias ya existentes y a los tiempos de reanudación actuales. La identificación del punto de partida permite a las empresas estimar la necesidad de realizar una acción en casos concretos de riesgos para la seguridad y también la inversión necesaria ligada a ella.

Selección de la estrategia de continuidad

Existen para las diversas contingencias internas o externas diferentes estrategias que prometen la continuidad del funcionamiento a pesar del fallo técnico o el rápido restablecimiento de la actividad. Para poder considerar qué estrategia es la más adecuada a sus servicios, los responsables de la gestión de la continuidad se basan en un análisis de costes y beneficios, que abarca factores cruciales como los medios económicos necesarios, la fiabilidad de la solución o el tiempo de reanudación estimado.

Si se trata de desarrollar un plan de continuidad para impedir un incendio en un centro de datos se puede recurrir a diversas soluciones, yendo desde la más modesta, consistente en una compensación de daños y perjuicios mediante un seguro de accidentes para empresas y un centro de datos de sustitución en el caso de un proveedor de alojamiento web, a una más exhaustiva (y cara) que incluiría la adaptación de las dependencias donde están instalados los servidores según estándares modernos de protección contra incendios. Si el aumento de la inversión es una opción, se logran reducir los costes que supondría construir o adaptar una segunda habitación para los servidores.

El siguiente paso es la elaboración de un plan de contingencia, que contiene las estrategias previamente elaboradas y provee de instrucciones concretas de acción para todos los escenarios de riesgo relevantes.